반응형

End-to-End Autonomous Driving과 관련된 다양한 게시물은

Introduction에서 확인하실 수 있습니다.

Imitation Learning (IL)

Expert action을 모방하여 에이전트가 정책(policy)을 학습하는 방법.

- 핵심 개념: 전문가가 주행하며 만든 궤적 데이터를 기반으로 학습.

- 목표: agent policy $\pi$가 expert_policy $\pi_\beta$와 일치하도록 학습.

- 출력 형태: 계획된 궤적(trajectory) 또는 제어 신호(control signals).

- Supervised Learning

- open-loop 형태의 평가가 적절.

데이터

- 조향각 제어 같은 라벨 달린 reference data 필요

- 보지 못한 상황에 노출되면 distribution 정보가 학습과 벗어나게 되고, 이에 대한 회복 능력 없음.

- unexplored state space

학습

- 사람 운전자의 행동을 모방하도록 E2E driving model을 학습시키는 방식.

- 전문가를 따라하도록 하는 방식.

- Behavior cloning과 Inverse Reinforcement Learning 등의 방식이 있음.

Behavior Cloning (BC)

expert의 행동을 모방하여 policy를 학습하도록 Agent를 훈련하는 지도 학습 방식.

- 데이터셋을 활용해 agent policy와 expert policy의 차이를 최소화함.

- $\mathbb E_{(s,a)} ℓ(π_θ(s),a)$

- 여기서 $ℓ(πθ(s),a)$은 agent action과 expert action 간 거리를 측정하는 loss function

- 초기 연구: 카메라 입력으로부터 제어 신호 생성 위해 e2e neural net 활용.

- multi-sensor inputs

- “Multi-modal fusion transformer for end-to-end autonomous driving”

- “Learning from all vehicles” - auxiliary tasks

- “Exploring the limitations of behavior cloning for autonomous driving”

- “Transfuser: Imitation with transformer-based sensor fusion for autonomous driving” - improved expert design

- “End-to-end urban driving by imitating a reinforcement learning coach” - 같은 향상된 기법들이 제안되어 BC 기반의 e2e driving 모델이 복잡한 도시 시나리오를 처리할 수 있도록 함.

장점:

- 간단하고 효율적

- RL처럼 복잡한 보상 설계 필요 없음.

- e2e 자율주행의 복잡한 도시 시나리오 처리 가능.

단점:

- covariate shift: 훈련 중 각 state를 독립적이고 동일한 분포로 취급하면서 생기는 문제.

- 해결 위해 몇 가지 on-policy 방법 제안.

- e2e 자율주행에서는 DAgger 사용. - causal confusion: imitator가 특정 입력 요소와 출력 신호 간의 잘못된 상관관계를 활용하고 이에 의존하게 되는 상황

Inverse Reinforcement Learning (IRL)

Expert의 demonstration을 활용하여 reward function을 역으로 학습하는 방법

- Inverse Reinforcement Learning, IRL이라고도 함.

Traditional IOC

- expert demonstration 기반으로 unknown reward function $R(s,a)$ 학습

- 이 보상 함수는 feature들의 linear combination으로 표현 가능.

- 연속적/고차원적 자율주행 시나리오에서는 reward의 정의가 암시적(implicit)이고 최적화 어려움.

Generative Adversarial Imitation Learning, GAIL

- expert와 학습된 policy를 구별하는 적대적(adversarial) 목표로 reward function 설계 → GAN과 유사

- 최근 연구: auxiliary perceptual task를 포함해 cost volume이나 cost function를 최적화하는 방안 제안.

Cost Learning Framework

- 궤적의 비용(cost)을 학습하고, 비용이 최소인 궤적 선택.

- BEV에서 학습된 cost volume과 다른 agent의 움직임을 조합.

- HD map, 다중 센서, 보조 작업 등이 통합된 데이터로 학습.

- e2e에서는 reasonable cost $c(⋅)$ 학습

- 알고리즘적 trajectory sampler를 사용해 최소 비용 가지는 trajectory $τ^∗$ 선택

cost design과 관련된 표현들

- BEV에서 학습된 cost volume

- 다른 agent의 미래 움직임에서 계산된 에너지와 결합.

- probabilistic semantic occupancy or free space layers

trajectory

- fixed expert trajectory set에서 sampling

- kinematic model 사용해 parameter sampling으로 처리

expert demonstration이 최소 비용을, 다른 trajectory는 높은 비용을 가지도록 유도하는 max-margin loss 사용.

Challenging Problems

- more realistic cost를 생성하기 위해 HD map, auxiliary perceptual task, 여러 센서들이 통합.

- 이는 multi-modal, multi-task framework에서 데이터셋 학습/구성 난이도 증가시킴.

그럼에도 불구하고, 앞서 언급된 비용 학습 방법들은 의사결정의 안전성과 interpretability 크게 향상.

이 논문에서는 해당 e2e 시스템 설계가 실제 응용 분야에 적합한 접근법인 것 같다고 언급함.

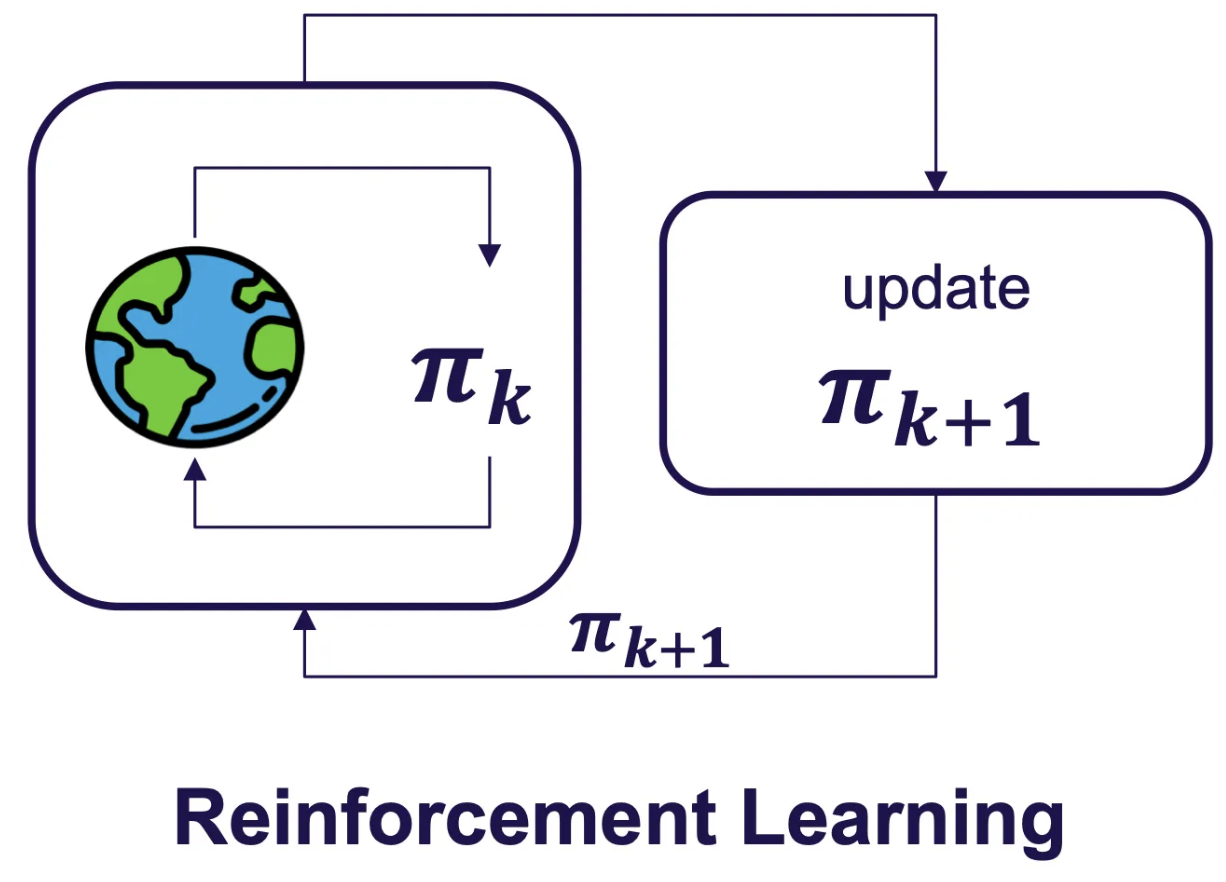

Reinforcement Learning

시행착오(trial and error)를 통해 학습하는 분야

시뮬레이션

- 새로운 데이터를 수집하기 위해 시뮬레이션 환경 및 IL보다 훨씬 더 많은 데이터가 필요

- RL을 운전에 사용하는 논문들은 대부분 시뮬레이션 사용.

- domain gap이 발생.

데이터

- 여러 환경에서 데이터를 병렬로 수집하는 방식을 자주 사용하며, 실제 상황에서는 어려움.

- unsupervised learning, 시뮬레이터 통한 상당한 양의 훈련 데이터 필요.

학습

- 매 순간 최적의 행동을 하도록 모델을 학습.

- 주행 환경에서 어떤 동작이 최상의 결과를 가져오는지 학습.

Deep Q Network, DQN

- Atari benchmark에서 인간 수준의 제어를 달성하면서 deep RL 대중화.

- 현재 state와 action을 입력받아 해당 행동의 discounted return을 예측하는 critic 또는 Q network라는 신경망을 학습합니다.

- 이후 policy는 가장 높은 보상을 예측하는 행동을 선택함으로써 암묵적으로 정의됨.

- 대부분은 DQN의 다양한 확장 사용

다양한 방식과 결합

- implicit affordances

- semantic segmentation 같은 지도학습 작업을 사용하여 CNN encoder를 사전 학습시킴.

- 이후 encoder를 고정하고 shallow policy head를 사용해 Q-learning의 modern version으로 학습.

- IL로 pre-training된 전체 네트워크를 fine-tuning하는 데 사용 가능.

- RL은 네트워크가 privileged simulator information을 사용할 수 있을 때 효과적으로 적용.

- Roach: privileged BEV semantic map에서 RL agent를 학습시키고, 이 policy를 사용해 데이터셋을 자동으로 수집하여 다운스트림 IL 에이전트를 학습시킴.

- WoR: Q-함수와 테이블 기반 Dynamic Programming을 사용하여 정적 데이터셋에 대해 추가적/개선된 label 생성.

Challenging Problems

- 현재까지 RL을 사용한 e2e 학습이 IL과 경쟁할 만한 결과를 보여준 사례는 없음.

- 학습을 통해 얻은 그래디언트가 운전에 필요한 deep perception architecture를 학습하기 충분하지 않은 가능성.

- Atari 같은 벤치마크에서 성공한 RL 모델은 상대적으로 얕은 구조로 몇 개의 층만으로 구성. - 시뮬레이션에서 실제 환경으로의 전환.

- RL의 목표는 reward function으로 표현되며, 많은 알고리즘이 환경의 각 단계에서 피드백을 제공하는 dense한 보상을 필요로 함.

- 현재 연구들은 일반적으로 충돌 회피와 같은 단순한 목표를 사용함 → 위험한 행동을 장려할 가능성. - 더 나은 보상 함수를 설계 및 학습의 어려움.

- sparse한 보상을 처리할 수 있는 RL 알고리즘을 개발하여 관련 지표를 직접 최적화할 수 있도록.

RL은 world model과 효과적으로 결합될 수 있지만 아직 문제가 있고, 현재 운전에 대한 RL 솔루션은 scene의 low-dimensional representation에 크게 의존하고 있음.

반응형

'Autonomous Driving > End-to-End Autonomous Driving' 카테고리의 다른 글

| [E2E 자율주행] (6)-2 Closed-loop: Parameter Initialization / Traffic Simulation (1) | 2024.12.09 |

|---|---|

| [E2E 자율주행] (6)-1 Benchmarking: Real-world / Closed-loop / Open-loop (2) | 2024.12.07 |

| [E2E 자율주행] (4) 발전과정 (1) | 2024.12.05 |

| [E2E 자율주행] (3) 개념 및 특징 (4) | 2024.12.03 |

| [E2E 자율주행] (2) 모듈러 자율주행 기술 (1) | 2024.11.29 |